简介

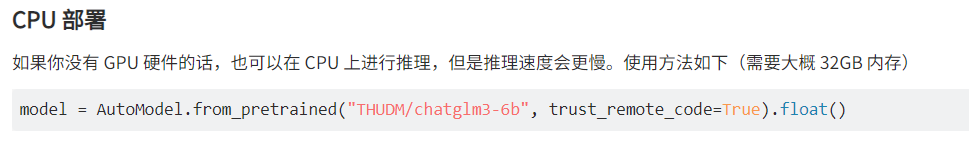

ChatGLM3介绍可自行查看(项目概览 - ChatGLM3 - GitCode),主要有如下这么一段,GPU贵,但是CPU便宜啊,这次就使用阿里云选一台按量付费的测试一下部署chatglm3-6b。

准备机器

选择ecs.g8i.2xlarge类型的机器,华东华北机房都行,注意有一些机房区域是没有的。

选用Ubuntu22.04系统,python和git都安装好了

选用Ubuntu22.04系统,python和git都安装好了

存储给100G,下载的模型文件较大

给分配公网IP,固定带宽5M

给分配公网IP,固定带宽5M

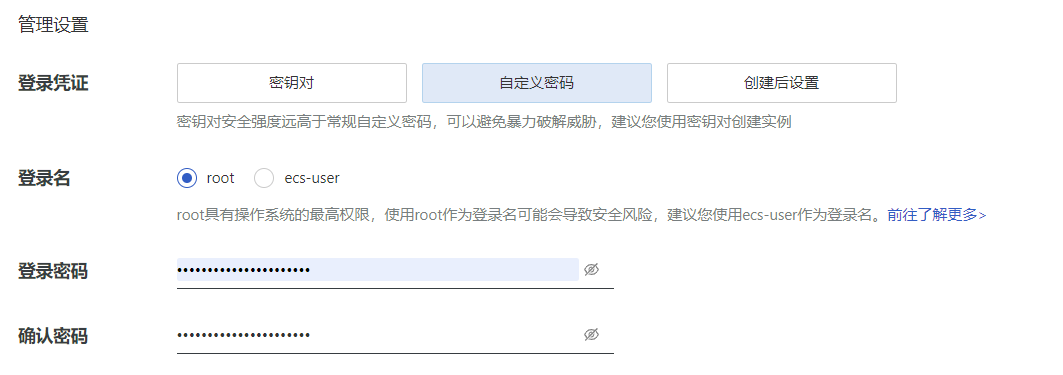

最后自定义root密码,用于远程连接访问

最后自定义root密码,用于远程连接访问

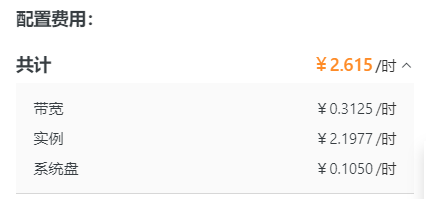

最后看一下,很便宜,一个小时两块多,记得测试完及时删掉

环境配置

下载ChatGLM3,可以通过国内gitcode下载,速度要快一点:

git clone https://gitcode.com/THUDM/ChatGLM3

使用豆瓣源安装依赖包(速度有点慢,耐心等待)

cd ChatGLM3

pip install -r requirements.txt -i http://pypi.douban.com/simple --trusted-host=pypi.douban.com

模型下载

模型文件较大,需要安装git-lfs

git-lfs安装检查:

git lfs install

Ubuntu下安装git-lfs

apt-get install git-lfs

通过国内魔搭社区下载模型文件(速度快一些)

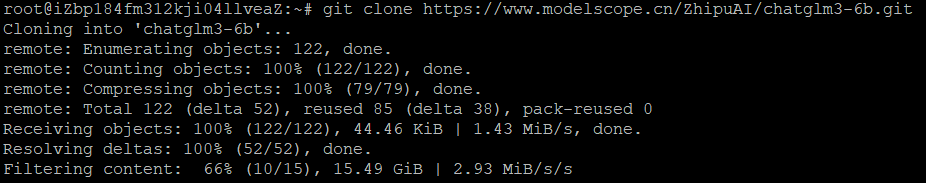

git clone https://www.modelscope.cn/ZhipuAI/chatglm3-6b.git

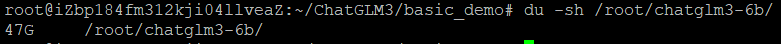

pwd 记录chatglm3-6b下载路径:/root/chatglm3-6b

注:执行下载后,要等待很长时间,文件较大:

最后总大小47GB。

最后总大小47GB。

运行试用

ChatGLM3提供了网页运行的demo,需要修改一些配置

cd ChatGLM3/basic_demo

配置基于 Gradio 的网页版 demo

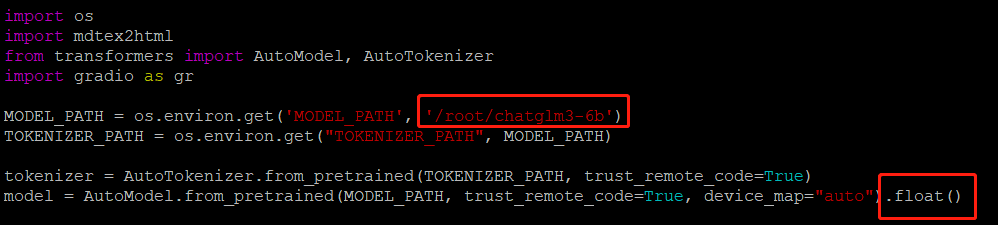

vim web_demo_gradio.py,填写本地模型文件的路径、修改运行使用CPU运行:

还有server_name改成0.0.0.0,这样才能被访问到

还有server_name改成0.0.0.0,这样才能被访问到

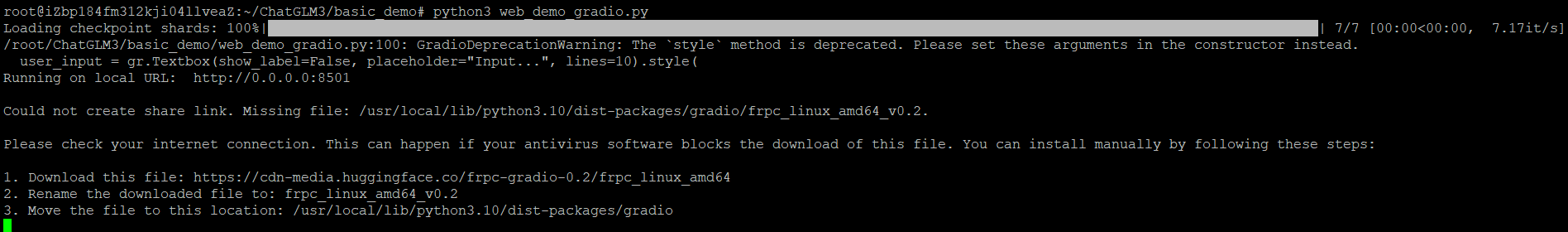

命令启动基于 Gradio 的网页版 demo:python3 web_demo_gradio.py

页面测试

页面测试

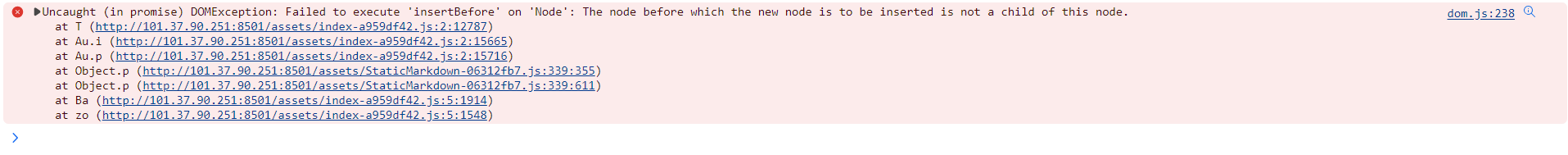

但是报错了,以后有空再搞,测试下一个demo

但是报错了,以后有空再搞,测试下一个demo

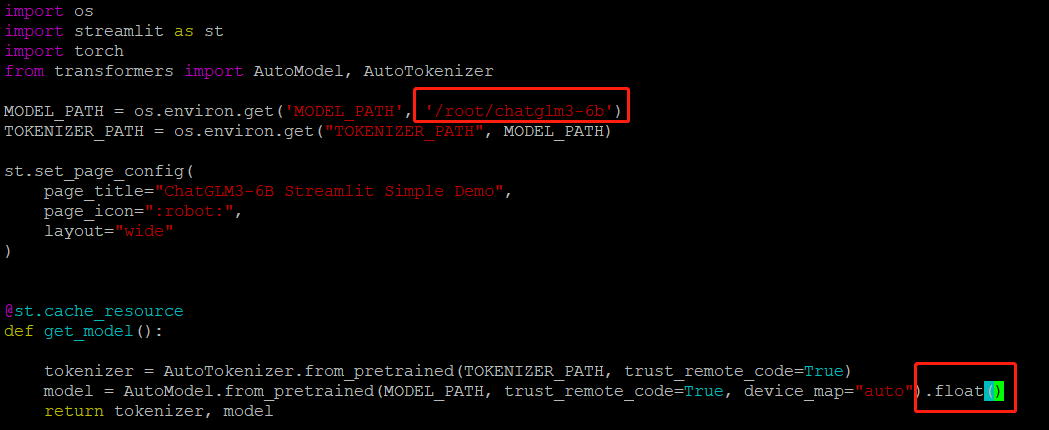

配置基于 Streamlit 的网页版 demo

vim web_demo_streamlit.py,填写本地模型文件的路径、修改运行使用CPU运行:

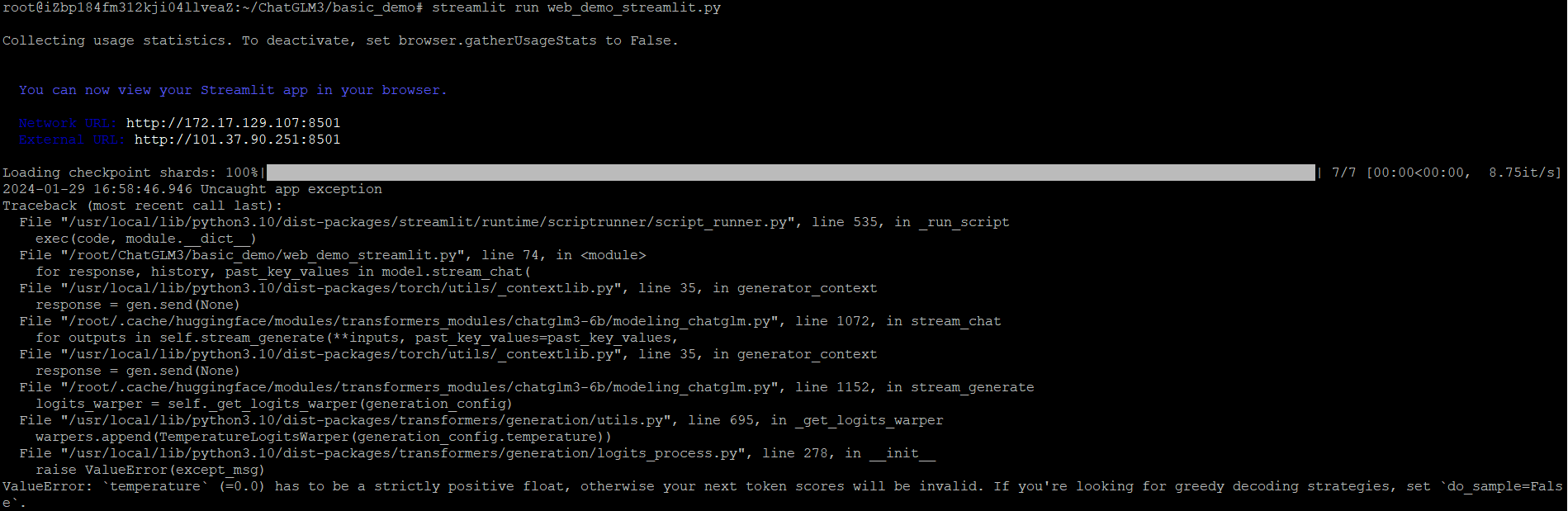

命令启动基于 Streamlit 的网页版 demo:streamlit run web_demo_streamlit.py

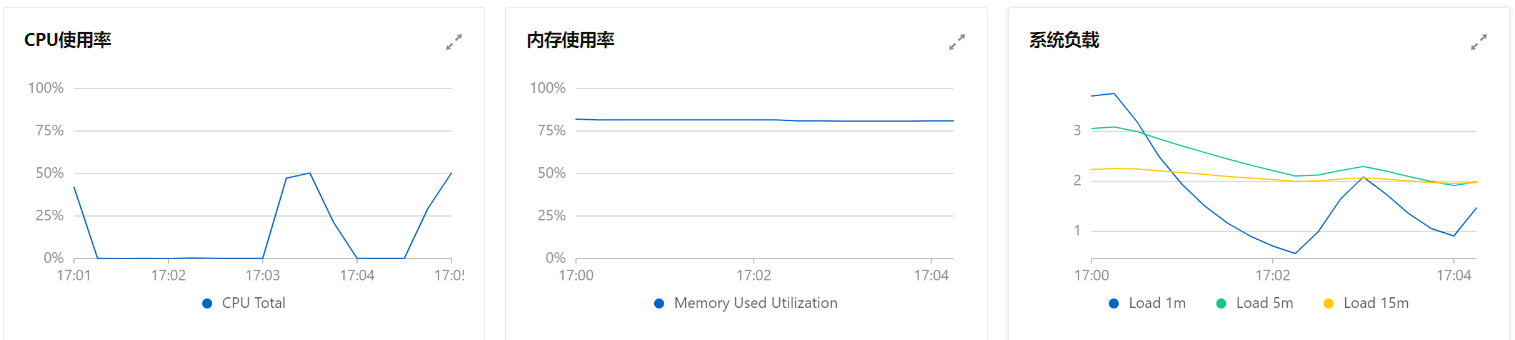

使用过程中,内存占用75%以上,CPU50%:

网页测试

网页测试